ISACA Journal | 部署负责任的AI的七大步骤

在众多行业中,采用人工智能(AI)提升业务流程已成为普遍趋势。诸如Open AI的ChatGPT和谷歌的Bard等大语言模型(Large Language Models, LLMs)的快速普及,为许多组织激发了新的创新举措,并使人们更加关注AI如何能够为企业带来收益。然而,企业在推动业务发展的同时需要平衡风险,必须做出明智的技术投资,包括对AI的投资。随着AI技术的迅猛发展,相关监管规定势在必行,各组织必须确保做好准备,通过部署负责任的人工智能(Responsible AI, RAI)应对这一变化。对于许多企业而言,RAI的部署正变得越来越重要,但实践中往往存在显著的差距。尽管很多组织认识到部署RAI的重要性,但真正实施并完善其RAI计划的比例却很小。一些专家甚至认为,除非受到法规强制执行的压力,否则部分组织可能不会主动采取措施最小化AI带来的风险。

当组织未能负责任地实施新技术时,会带来相应的后果。这些后果可能包括声誉损害、法律诉讼、监管机构的强烈反弹、隐私问题、责任归属不明确以及员工和客户信任度下降等。鉴于这些潜在后果,对于各组织而言,至关重要的是在考虑即将出台的欧盟AI法案等法规以及其他全球监管举措的前提下,采用全面的负责任的人工智能(RAI)方案。

定义负责任的AI(RAI)

RAI的一般定义是开发和使用符合道德原则与价值观的人工智能,这些原则包括但不限于透明度、公平性、可问责性、隐私保护、安全性、准确性和监督等要素。尽管根据所选择的框架,这些核心要素可能会稍有差异,但RAI并不仅仅是一种处理人工智能的具体方法,而是一个关注在识别、定义和管理AI系统过程中所需复杂实践的术语,同时确保对部署系统的适当监督和问责制。这类技术可以用于从数据中获取洞见,但必须考虑这些策略如何产生风险以及这些策略带来的独特挑战。随着各行各业的组织不断将人工智能与自身业务流程结合,企业逐渐认识到这项技术是一把双刃剑。

将RAI付诸实践

治理在组织内部影响决策、文化和控制,并确保责任落实,保持执行的一致性,并确保决策与组织领导层的目标保持一致。各组织必须在实施RAI的过程中建立相应的治理机制。围绕共享术语和核心AI概念的培训至关重要,确保领导层在制定战略决策时理解所采用的技术。对基础AI主题有充分的认识有助于确保所实施的RAI项目具有针对性,并且建立的治理体系与组织目标相符。如果没有适当的培训,组织内的个人可能无法识别或理解AI所带来的潜在风险。通过设定基准并培训所有相关方,组织能够清晰地了解已部署系统的使用情况及其带来的特定风险,使领导层能够评估系统可能导致的新威胁和危害源。在整个过程中满足RAI的核心原则至关重要。部署系统的风险是动态变化的,今天识别出的风险可能在六个月或一年后有所不同。因此,组织必须不断评估并根据需要更新RAI计划。

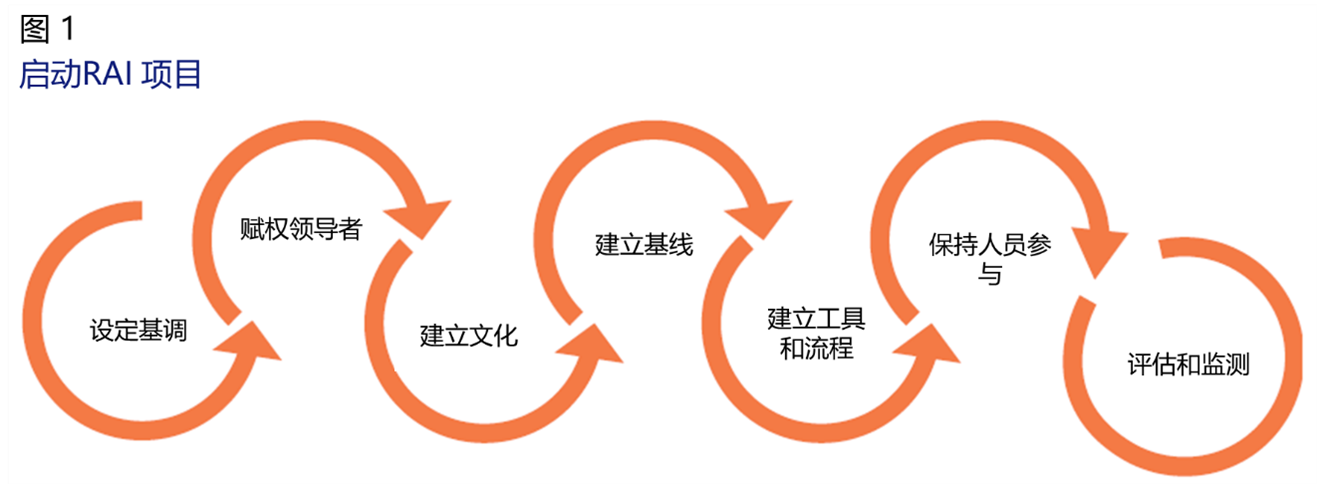

RAI是一项随着组织成熟度不断提高而不断发展的追求。领导者应考虑如何通过RAI计划推动业务发展并对利益相关方产生积极影响。采用如图1所示,借鉴了多方面的策略方法,能够帮助企业在扩大其RAI项目规模的同时实现关键收益。建立组织在RAI方面的基线,包括标准、控制措施和工具,有助于聚焦RAI战略,并随着成熟度提升提供跟踪项目演变的能力。

启动RAI计划的基本组成部分包括七个步骤:

-

步骤一:为RAI设定基调——组织必须在执行领导层确立基调,确保清晰的理解和传达RAI的优先级和伦理考量。领导者应明确界定在何时何地使用AI的期望标准。

-

步骤二:赋权领导者——组织内部应指派并授权负责人设定期望、推动变革并制定全面的RAI计划。

-

步骤三:建立RAI文化——组织应当创建并全面接受RAI行为准则,该行为准则包含定义RAI项目如何与组织目标、价值观和原则一致的原则。RAI项目应该吸纳多元视角和多个利益相关方的反馈,并将此原则贯彻整个项目实施过程。此外,组织还应营造能够有效报告和解决关注问题的环境,包括在整个实施过程中征求公开反馈,并确保所有提交的问题和报告的关注点得到恰当评估。

-

步骤四:进行初步风险评估并建立成熟度基准——完成风险评估是一个持续且不断发展的过程。组织必须具备评估部署系统可能带来的风险的战略。尤其当实施的系统可能会大规模造成伤害时,这一点尤为重要。AI应用可能导致伤害的领域众多,如招聘流程、对再次犯罪的决策、深度伪造、错误信息(虚假信息)、隐私问题、财务决策、武器系统自动化决策以及其他因数据集偏见或模型开发引起的不良影响。当前风险应当识别出来,潜在影响需要进行评估,并确定补救或缓解策略。同时,组织也必须理解数据、模型和系统的局限性。通过理解设计系统的输入输出以及预期结果,组织可以确保所设计系统的范围能够实现预期效果。

-

步骤五:使用适当的工具和流程——组织应努力部署无偏见、透明和安全的算法。尽管完全公正或无偏见的系统在真实反映社会的系统中无法存在,但目标应该是平衡技术实施并理解具体系统的影响。应当建立处理数据集、工程师和环境中的潜在偏见的流程,在RAI项目中适当考虑并减轻这些偏见。

-

步骤六:保持人员参与——在整个过程中,利益相关方的反馈应包括不同背景和观点。特别是在有可能对社会产生重大不均衡影响的环节中,保持人类参与决策至关重要。

-

步骤七:监测和审计RAI计划及AI部署——确保对已识别风险进行持续评估,检测和了解AI系统内部风险如何演变。通过内部审计和持续监测RAI计划及部署的技术,确保由于诱导偏见、设计或其他可控属性导致的意外伤害不会发生,从而有助于组织识别改进空间并最大限度地减少对社会的非预期影响。独立审计RAI计划可以确保适当控制措施就绪并与外部监管要求保持一致。

负责任的人工智能成熟度

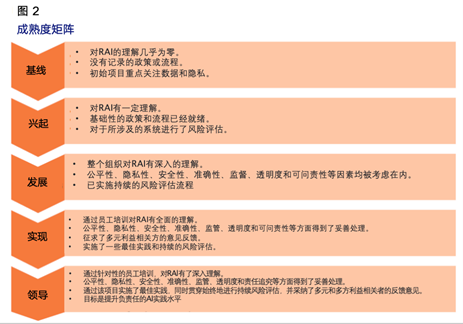

利用成熟度模型可以为组织评估自身所处位置及所需改进之处提供指导。组织可以通过这种方法规划路径,提高自身RAI计划的成熟度。微软和IBM等公司提供的成熟度模型可作为参考,在组织整个RAI旅程中引导RAI计划的发展。在RAI计划初期,应当从整体角度予以评估。图2展示了用于评估项目层面成熟度的通用指南。

结论

确保组织以深思熟虑和负责任的方式设计和部署AI技术,创造价值、推动利润增长并建立信任的同时能够通过防止AI对社会造成负面影响。组织必须识别当前存在的缺口,并利用现有的AI框架和行业指导等工具填补这些缺口。建立RAI计划有助于防止AI系统用于延续偏见和歧视;确保AI系统具有可解释性,配备适当的隐私和安全控制措施,并在多元利益相关方的参与下开发AI系统;同时,对于因AI系统造成的任何损害,要追究相关人员的责任。

组织采用新技术的同时,应考虑部署RAI计划,并利用成熟度矩阵了解自身所处位置及需要关注的领域。这对于构建将AI用于善而非恶的未来至关重要。实施RAI可以促进更有效的沟通、增强协作,并更加专注于产品优化,从而提高产品质量、减少错误,并最终提升生产力。那些积极主动地采纳负责任AI实践的组织将有助于创造一个更加光明、可持续的未来。

.png)